[더구루=홍성일 기자] 알파벳의 인공지능(AI) 자회사 구글 딥마인드(Google DeepMind)가 스탠퍼드 대학교 연구진과 손잡고 대형언어모델(LLM)의 '환각' 문제를 해결하기 위한 사실 확인 툴(팩트 체커) 솔루션을 개발했다.

1일 업계에 따르면 구글 딥마인드는 스탠퍼드 대학교 연구진과 SAFE(Search-Augmented Factuality Evaluator)라는 자동 평가 프레임워크를 도입했다. SAFE는 LLM에서 생성된 콘텐츠의 사실성(factuality)을 평가하는 단계를 자동으로 수행하도록 설계됐다.

LLM 생성 콘텐츠의 사실성을 확인하는 것은 AI의 신뢰성 확보를 위해서 핵심적인 프로세스다. 특히 생성형 AI의 문제점 중 하나가 환각인 점을 봤을 때 이런 과정은 필수적이라고 할 수 있다. 환각은 생성형 AI가 실제로는 없거나 사실이 아닌 정보를 사실인 것마냥 출력하는 현상을 말한다.

그동안은 이런 환각증세가 발생했을 때 주석자(어노테이터, annotators)들이 수동을 일일이 확인해 모델을 개발해왔다. 오픈AI도 챗GPT를 개발하면서 이런 과정을 거쳐 답변의 정확성을 높인 것으로 알려져있다.

SAFE는 이 작업을 자동으로 진행할 수 있게 만든 것이다. SAFE는 답변의 분석, 처리 및 평가를 4단계에 걸쳐 진행한다. 우선 답변을 개별 사실로 분할하고 이를 수정한 후 구글의 검색 결과가 비교한다. 그리고 개별 질문과 원래 질문의 관련성을 확인해 정확성과 사실 여부를 검증한다.

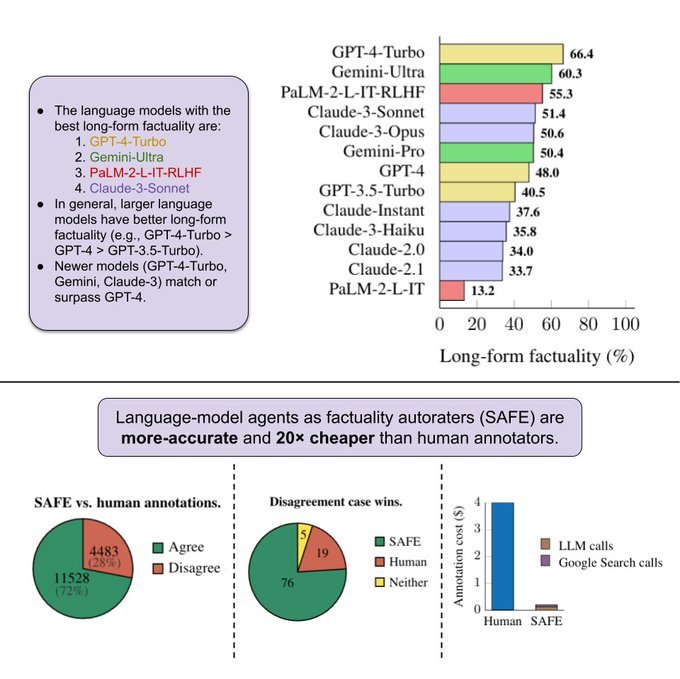

구글 딥마인드 연구진은 약 1만6000개의 팩트로 구성된 데이터 세트인 롱팩트(LongFact)를 구성하고 13개 LLM을 이용해 시스템 테스트를 진행했다. 테스트 결과 SAFE는 인간 주석자와 72% 사례에서 동일한 결과를 제공했으며 의견이 일치하지 않는 경우에도 SAFE는 76%에서 정확한 결과를 보여줬다.

구글 딥마인드는 SAFE가 전문적인 팩트 체커를 고용하는 등 수동 시스템을 갖추는 것보다 20배 가량 저렴할 뿐 아니라 대규모로 적용할 수 있다고 설명했다.

업계 관계자는 "SAFE는 사실성 확인을 위한 확장 가능하고 비용 효율적인 방법을 제공한다"며 "이를 통해 LLM이 생산한 정보의 신뢰성을 향상시켜 AI분야를 크게 발전시킬 수 있을 것"이라고 말했다.